Какие сайты индексирует поисковая машина?

Домены

Очень важно понимать, где находятся пределы зоны индексирования поисковика, какие сайты можно в нем найти, а какие нет, какие сайты можно добавить в поисковик, а какие нет. Хотя «Яндекс» и «Рамблер» — поисковые машины по русскоязычным сайтам, то есть по Рунету, это не значит, что они индексируют только сайты с именами в зоне .ru. В оба поисковика можно добавить сайт с расширением .com, .info и другими, но при этом он должен быть на русском языке. До сайтов из этих и других доменных зон «Яндекс» и «Рамблер» добираются и сами, если на них ведут ссылки с ресурсов, уже известных данным поисковикам. С 2007 года «Яндекс» «перешел границу» и начал самостоятельно индексировать мировой Интернет, в настоящее время он «знает» уже миллиарды англоязычных страниц.

Google, который позиционирует себя как мировую поисковую машину, естественно, индексирует вообще любые сайты во всех доменных зонах.

Какие документы индексируют поисковики?

Протокол HTTP (англ. HyperText Transfer Protocol) — методика передачи веб-страниц по сети Интернет.

Изначально целью поисковиков было проиндексировать веб-страницы, то есть тексты в формате HTML, выложенные на сайт и отображаемые веб-сервером по протоколу НТТР. Позже обнаружилось, что много полезной информации выложено в Интернете в виде статей, прейскурантов, документации, руководств и т. п. в разных «офисных» форматах. Поэтому большинство поисковиков несколько лет назад начали индексировать выложенные на сайтах документы в форматах MS Word, PDF, MS Excel. Широкое распространение динамических страниц в формате Flash заставило поисковиков индексировать и тексты, скрытые внутри этого формата файлов.

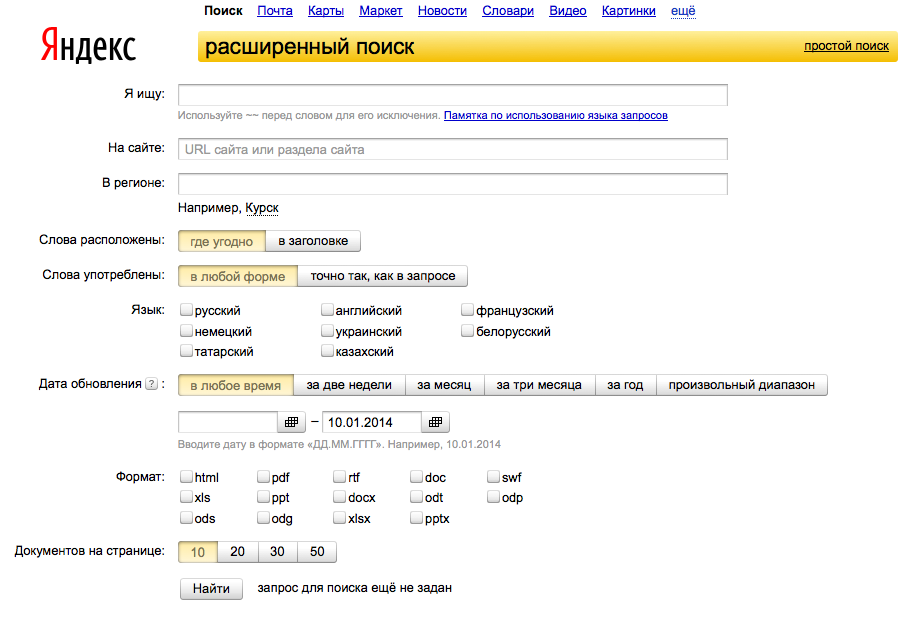

Страница расширенного поиска “Яндекса”

Однако не стоит рассчитывать на индексацию вашей информации в этих экзотических для Интернета форматах, поскольку нет гарантии, что поисковик проиндексирует их хорошо. Если есть возможность, любые важные тексты всегда следует дублировать на сайте в формате HTML.

Например, нужно всегда иметь прейскуранты в виде обычной веб-страницы, потому что до прейскуранта в формате Excel поисковик может не добраться, а если и доберется, то индексация, поиск и показ его в результатах поиска будут обязательно хромать, поскольку поисковики не умеют разбирать структуру Excel-файлов настолько же хорошо, как HTML-страницы.

Постоянно появляются новости и слухи о том, что Google или «Яндекс» начали наконец в какой-то степени «понимать» JavaScript. Пока, тем не менее, полагаться на это не стоит.

Заметим, что поисковики не индексируют тексты, которые выводятся на экран пользователя динамически разными программными средствами наподобие JavaScript. Они так же невидимы для поисковика, как и тексты в графическом виде, о которых говорилось выше.

Глубина и объем индексации

Насколько глубоко поисковик «зарывается» в сайт и есть ли какие-либо ограничения?

Теоретически таких ограничений нет, однако на практике поисковик не станет выкачивать с вашего сайта миллионы страниц (если они там есть). Ведь кроме вашего сайта у поисковика в очереди на индексацию стоят миллионы других сайтов, поэтому он старается за один раз, за один проход взять с каждого сайта некоторое разумное количество страниц. В следующем цикле индексации поисковик может взять еще какое-то количество ваших страниц и т. д. Чтобы не брать каждый раз слишком много, поисковик старается не погружаться по ссылкам внутрь вашего сайта слишком глубоко.

Это означает, что даже при большом количестве страниц сайт должен быть разумно организован — скажем, не должно быть страниц, до которых можно добраться только по цепочке из десяти ссылок. В разделах «Как сделать сайт доступным для поисковых систем» и «Коррекция сайта для продвижения в поисковых системах» мы расскажем об этом подробнее.

| Что такое машинная морфология | Индексация баз данных |